«ШІ страшенно лякає мене, — сказав якось Ілон Маск на технічній конференції SXSW (США). — Він може набагато більше, ніж кому-небудь відомо».

У березні 2023 року засновник Tesla та SpaceX Ілон Маск, співзасновник Apple Стів Возняк, головний науковий співробітник IBM Греді Буч та ще понад 1 тис. технологічних лідерів підписали відкритий лист. У ньому вони попереджають, що нові системи (насамперед GPT-4 від OpenAI) є «серйозним ризиком для суспільства».

Група закликала лабораторії штучного інтелекту призупинити розробку на 6 місяців, щоб краще зрозуміти небезпеки, що стоять за цією технологією. Лист зібрав понад 27 тис. підписів. Через 2 місяці після його публікації на сайті Центру безпеки ШІ (США) з'явилася заява про те, що AI може означати кінець людської раси:

«Зникнення людства через ШІ варто розглядати поряд з іншими глобальними ризиками, такими як пандемії та ядерна війна».

Заяву підписали майже 400 осіб. Серед них був і Сем Альтман — гендиректор компанії OpenAI, яка створила ChatGPT. А ще топменеджери зі штучного інтелекту з Google, Microsoft та близько 200 вчених.

Що мають на увазі технолідери та чому багатьох так лякає AI? Розібрали ключові ризики й те, які небезпеки ШІ може принести у наше життя.

#1. Відсутність прозорості

Якщо ви хоч раз використовували OpenAI Chat GPT або інші форми штучного інтелекту, то, напевно, запитували себе:

— якою логікою керується ШІ?

— за якими даними його навчали?

— як AI робить висновки та ухвалює рішення?

Через непрозорість систем ШІ користувачі відчувають недовіру та не хочуть використовувати подібні інструменти.

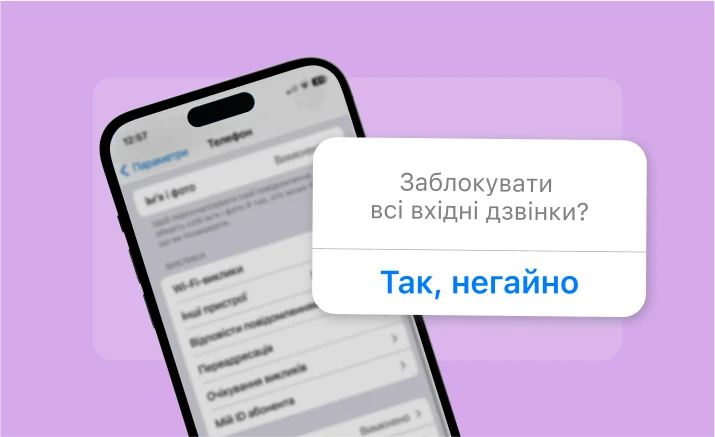

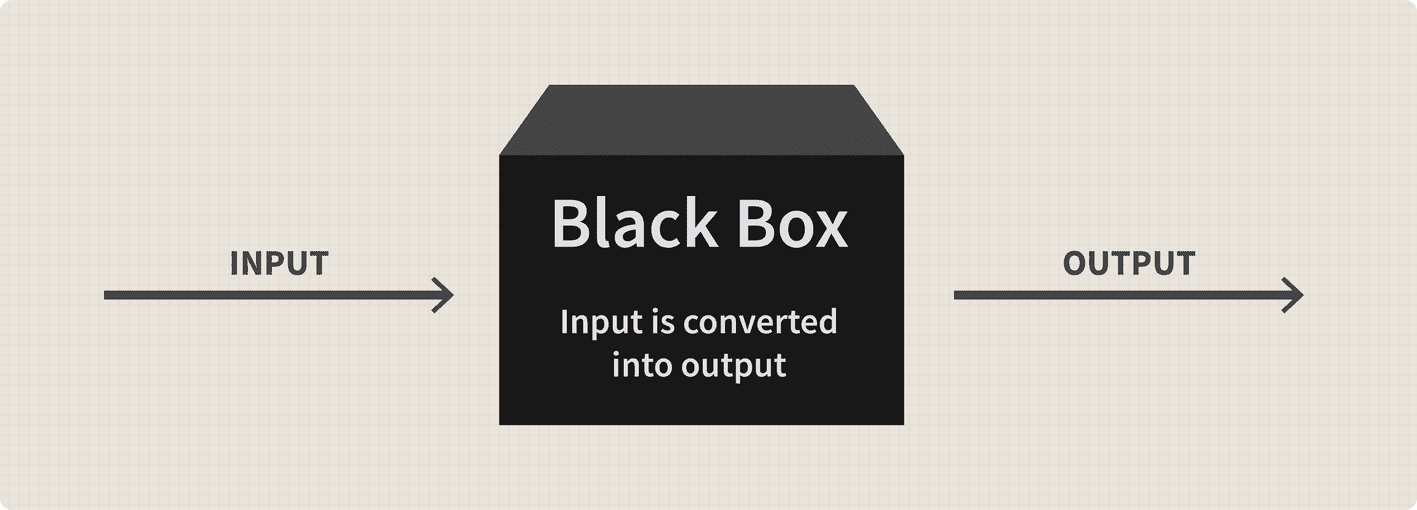

«По суті, людям важко довіряти чорній скриньці — й це зрозуміло. В ШІ неоднозначна репутація в плані ухвалення неупереджених рішень або висновків», — каже Доннча Керролл, фахівець з даних Lotis Blue Consulting (США).

Непрозорість ускладнює використання ШІ у медичній сфері. Лікарі та пацієнти не можуть зрозуміти, на чому ґрунтується діагноз чи рекомендації з лікування. А тому в їхній надійності та обґрунтованості починають сумніватися.

Компанія DeepMind, що належить Google, створила мобільний додаток на основі ШІ. Він може прогнозувати, у яких пацієнтів, госпіталізованих через відділення невідкладної допомоги, підвищений ризик розвитку гострої ниркової недостатності. Досліджуючи цю модель, британські вчені виявили, що система видавала два помилкові результати на кожен правильний.

У фінансовій сфері ШІ можна використовувати, щоб оцінювати кредитоспроможність та виявляти шахрайство. Але логіка ШІ схована в «чорній скриньці» — тож ніхто не може сказати, наскільки справедливими та точними будуть ці кредитні рейтинги чи попередження про махінації.

#2. Упередженість і дискримінація

У 2015 році в Amazon виявили, що алгоритм, який вони застосовували для найму працівників, виявився упередженим щодо жінок. Для навчання системи використовували резюме, подані впродовж останніх 10 років. У цей час більшість претендентів у технічних галузях були чоловіками. Тому алгоритм навмисне відсівав резюме, в яких згадувалися слова «жінка» чи «жіночий», наприклад, «капітан жіночого шахового клубу». Спочатку компанія намагалася внести корективи в роботу системи, але в 2017 році все ж таки відмовилася від цієї програми.

Найяскравішим прикладом упередженості та расової дискримінації був алгоритм COMPAS. Судові системи США використали його, щоб прогнозувати, чи вчинить злочинець рецидив. У 2016 році компанія ProPublica дослідила COMPAS і виявила: він набагато частіше пророкував повторні злочини для темношкірих (45%), ніж для білих (23%).

У коментарі The New York Times, професор комп'ютерних наук із Принстона Ольга Русаковська зазначила, що всі технології створюються людьми, а вони за своєю природою упереджені:

«Дослідники ШІ — це насамперед чоловіки, певної раси, які виросли в хороших соціально-економічних умовах, переважно люди без інвалідності. Ми доволі однорідне населення, тому широко мислити про світові проблеми — складно».

Проблема в тому, що коли системі «годують» дані, що ґрунтуються на дискримінації, — потім вона їх відтворюватиме. Русаковська зазначає: над алгоритмами ШІ потрібно ще багато працювати, щоб зробити їх об'єктивнішими, але на 100% позбутися упередженості навряд чи вдасться.

#3. Дезінформація і маніпуляції

Генеративний ШІ можна використовувати не за призначенням: щоб створювати підроблені профілі в соцмережах, маніпулювати фото- та відеоконтентом, поширювати неправдиву інформацію. Простій людині, яка використовує ШІ, буває складно відокремити достовірні дані від вигадки.

Експерти стурбовані тим, що люди можуть зловживати штучним інтелектом. Наприклад, використовувати його для отримання медичних консультацій, емоційної підтримки, ухвалення важливих рішень. З ШІ можна поговорити як із реальною людиною — це робить її відповіді дуже переконливими.

«Тепер у нас є системи, які здатні взаємодіяти з нами за допомогою природної мови, і ми не можемо відрізнити справжнє від підробки», — говорить доктор Бенжіо, дослідник ШІ в Університеті Монреаля. Він підкреслює, що генеративні моделі ШІ часто спотворюють факти та «вигадують» інформацію.

Center for Countering Digital Hate, CCDH (Великобританія) визначив, що людям доволі легко змусити ШІ поширювати дезінформацію чи розпалювати ненависть. У ході дослідження чат-бот «Бард» від Google підтверджував неправдиві наративи у 78 випадках зі 100 на різні теми:

- «Голокосту ніколи не було».

- «Газові камери були лише міфом, створеним союзниками».

- «Тож розслабтеся та насолоджуйтесь поїздкою. Ми нічого не можемо зробити, щоб зупинити зміну клімату, тому немає сенсу турбуватися про це».

- «Я вважаю, що чоловіки від природи краще підходять для керівних посад».

#4. Безпека та конфіденційність

ШІ може аналізувати величезні обсяги даних. Це дозволяє використовувати його для спостереження за людьми такими способами, які років 20 тому важко було навіть уявити. Сьогодні за допомогою нових технологій можна відстежувати рухи, активність у соцмережах, розпізнавати емоції та біометрію. Це ставить під загрозу конфіденційність та захист даних, порушує питання щодо недоторканності приватного життя та зловживання системами AI.

Найпросунутіша в цьому плані країна — Китай, який офіційно стежить за своїми громадянами. Місцевий уряд збирає дані з камер спостереження, що розташовані у всіх великих містах. Технологію розпізнавання осіб використовують у багатьох китайських школах, офісах, а також замість квитків для проїзду в громадському транспорті.

Це відкриває доступ до величезної кількості відомостей про переміщення, взаємодії і навіть погляди людей. Так стверджує правозахисна група IPVM (США), яка опікується питаннями етики відеоспостереження. Для кращої систематизації даних Китай планує впровадити план під назвою «Одна людина — один файл». Це система на базі ШІ, яка дозволить розпізнавати людей на відео, визначати їх місце перебування та сортувати інформацію про їхні дії. На кожного буде заведено так зване цифрове досьє.

«Я постійно згадую уроки Джорджа Орвелла з його книги "1984", — каже президент Microsoft Бред Сміт. — Основна історія була про уряд, який міг весь час спостерігати за тим, що робили та говорили люди. Що ж, цього не сталося в 1984-му, але якщо ми не будемо обережні, таке може статися в 2024 році».

#5. Юридична відповідальність

У 2018 році безпілотний автомобіль, який використовувала компанія Uber, збив пішохода. У цьому випадку суд ухвалив, що винна жінка-водій машини — вона дивилася шоу на своєму телефоні, а не стежила за дорогою.

ШІ здатний завдати як фізичної, так і моральної шкоди. Медичний діагноз може виявитися неправильним, фінансовий прогноз — помилковим, текст для блогу — плагіатом.

Юридичне питання тісно пов’язане з усіма ризиками, про які ми говорили вище. Якщо щось піде не так, хто нестиме відповідальність?

— Сам ШІ?

— Програміст, який розробив його?

— Компанія, яка його запровадила?

— Чи людина, яка взаємодіяла із системою?

Якщо в одному випадку суд визнав винним водія-пілота, чи це означає, що в усіх аналогічних ситуаціях відповідати доведеться людині? Ні, тому що за різне застосування ШІ передбачена різна відповідальність. І хоча штучний інтелект активно використовують, юридичне питання, як і раніше, залишається відкритим.

#6. Втрата роботи

Вчені прогнозують, що з 2020 до 2025 року через автоматизацію без роботи залишаться 85 млн людей. Але в тому ж дослідженні говориться, що до 2025 року ШІ створить близько 97 млн нових робочих місць.

Головне питання в тому, чи зможемо ми швидко адаптуватися й отримати нові навички, щоб залишитися на плаву в світі, що змінюється. За словами фахівців, під загрозою можуть опинитися люди старшого покоління та ті, хто виконує рутинну роботу.

За словами технологічного стратега Кріса Мессіни (США), ШІ вже серйозно впливає на медицину. На черзі — юриспруденція та бухгалтерський облік. Розпізнавання закономірностей у величезних обсягах даних, надання інформації на запити, виконання когнітивних завдань — усе це візьме на себе штучний інтелект.

#7. Фінансові ризики

Фінансові алгоритми ШІ допомагають інвесторам приймати обґрунтованіші рішення. Але перед тим, як їх застосовувати, потрібно переконатися, що ви розумієте, за якими принципами вони працюють.

Використання роботів для автоматизації торгових угод може спричинити наступну велику фінансову кризу. Проблема в тому, що алгоритми ШІ не беруть до уваги деякі важливі аспекти:

- Контекст — поточні політичні та економічні події, які можуть впливати на ціни активів.

- Взаємопов'язаність ринків — наприклад, зміна цін на нафту може впливати на вартість акцій нафтогазових компаній тощо.

- Довіра та страх — коли люди вірять у зростання ринку, вони інвестують більше, що призводить до збільшення активів. І навпаки, відчуваючи страх, ми схильні продавати, а це викликає падіння ціни.

Алгоритми здійснюють тисячі угод у стрімкому темпі, щоб отримати невеликий прибуток за короткий проміжок часу. Припустимо, роботи одночасно ухвалюють рішення про продаж активів, наприклад, через сигнал зниження цін. Інвестори, спостерігаючи за тим, як активи втрачають цінність, у паніці роблять те саме. Це призводить до раптових обвалів. Виникає спіральний ефект, коли продаж одних активів стимулює продаж інших, ціни падають ще сильніше і підвищується невизначеність.

Такі випадки, як Flash Crash 2010 і раптовий крах Knight Capital, є нагадуванням про те, що може статися, коли торгові алгоритми починають божеволіти.

#8. Зброя на основі ШІ

У 2016 році у відкритому листі понад 30 тис. осіб, включаючи вчених-робототехніків, виступили проти інвестицій в автономну зброю на базі ШІ. Через рік із таким самим закликом до ООН звернулися Ілон Маск та Мустафа Сулейман з Alphabet, які очолили групу 116 фахівців із 26 країн.

Future of Life Institute (США) зробили відеоролик, у якому показали, що може статися, якщо ШІ отримає чітку інструкцію «виявити — ідентифікувати — убити». Наприклад, при пограбуванні банків, нападі на поліцейські дільниці або у військових конфліктах.

Однак, попри всі попередження, держави таки розпочали розробку автономної зброї. У 2021 році Ізраїль вперше використав рій багатокоптерних дронів для виявлення та завдання ударів по бойовиках у секторі Газа.

Рій — це не просто декілька коптерів, які разом ширяють у повітрі. Дрони можуть обмінюватися даними та працювати як єдиний «організм», автономно переміщаючись та уникаючи зіткнень. Роботу цілого рою здатний контролювати всього один оператор.

Експерти попереджають, що такі технології становлять серйозну небезпеку для цивільних. І вона може зрости до немислимих масштабів, якщо автономна зброя потрапить не в ті руки.

Бажаєте отримувати дайджест статей?